python - 我寫的Xpath 為什么爬取不到內容

問題描述

-- coding:utf-8 --import lxml,requests,sysfrom bs4 import BeautifulSoupfrom lxml import etree

reload(sys)sys.setdefaultencoding('utf-8')

def main():

url = ’https://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%E6%9A%B4%E8%B5%B0%E6%BC%AB%E7%94%BB&pn=0’req = requests.get(url).content

# soup = BeautifulSoup(req.content,’lxml’) # imgs = soup.find_all(’img’)

content = etree.HTML(req)paths = content.xpath(’//*[@id='imgid']/ul/li[1]/a/img/text()’)# for img in imgs:## print img

# for img in imgs :

print paths

main()

問題解答

回答1:在寫爬蟲的時候,使用xpath一定要確認一下網頁的源代碼中是否有數據,如果沒有,說明是異步加載的

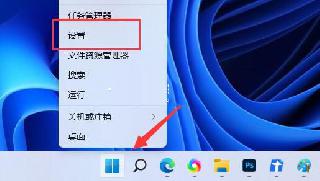

1. 瀏覽器輸入這個連接即可看源代碼,ctrl+f 查找imgid所在的位置view-source:https://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%E6%9A%B4%E8%B5%B0%E6%BC%AB%E7%94%BB&pn=02. 發現

并沒有找到下面的圖片列表,我們可以判定圖片是js加載的

3. 尋找F12看network(刷新才能看到),并沒有發現異步請求加載的圖片信息,于是我猜測數據應該就在html里,不過是放在js里,在加載圖片的時候處理了

同樣是上面的查看源代碼的方式,查找objURL這個參數發現了真實的url

//很多,集中在html下半部分http://img3.duitang.com/uploads/item/201608/06/20160806110540_MAcru.jpeg解決

剩下的就交給你啦~去想辦法解析出下面部分的真實url吧!

相關文章:

1. javascript - vue 移動端的input 數字輸入優化2. java - mongodb分片集群下,count和聚合統計問題3. java - 自己制作一個視頻播放器,遇到問題,用的是內置surfaceview類,具體看代碼!4. android - java 泛型不支持數組,那么RxJava的Map集合有什么方便的手段可以定義獲得一串共同父類集合數據呢?5. 服務器端 - 采用nginx做web服務器,C++開發應用程序 出現拒絕連接請求?6. 為什么我ping不通我的docker容器呢???7. 關于docker下的nginx壓力測試8. python - pandas按照列A和列B分組,將列C求平均數,怎樣才能生成一個列A,B,C的dataframe9. javascript - 有什么兼容性比較好的辦法來判斷瀏覽器窗口的類型?10. java - 靜態屬性中的賦值和靜態代碼塊中的賦值有什么區別?

網公網安備

網公網安備