文章詳情頁

Python爬蟲基礎之簡單說一下scrapy的框架結構

瀏覽:112日期:2022-06-15 17:22:21

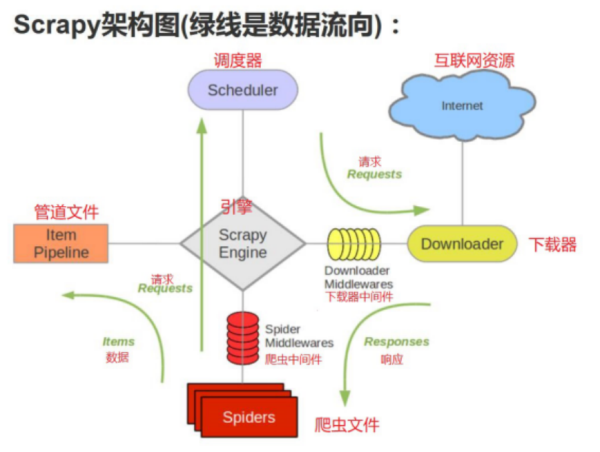

scrapy 框架結構

思考

scrapy 為什么是框架而不是庫? scrapy是如何工作的?項目結構在開始爬取之前,必須創建一個新的Scrapy項目。進入您打算存儲代碼的目錄中,運行下列命令:

注意:創建項目時,會在當前目錄下新建爬蟲項目的目錄。

這些文件分別是:

scrapy.cfg:項目的配置文件 quotes/:該項目的python模塊。之后您將在此加入代碼 quotes/items.py:項目中的item文件 quotes/middlewares.py:爬蟲中間件、下載中間件(處理請求體與響應體) quotes/pipelines.py:項目中的pipelines文件 quotes/settings.py:項目的設置文件 quotes/spiders/:放置spider代碼的目錄Scrapy原理圖

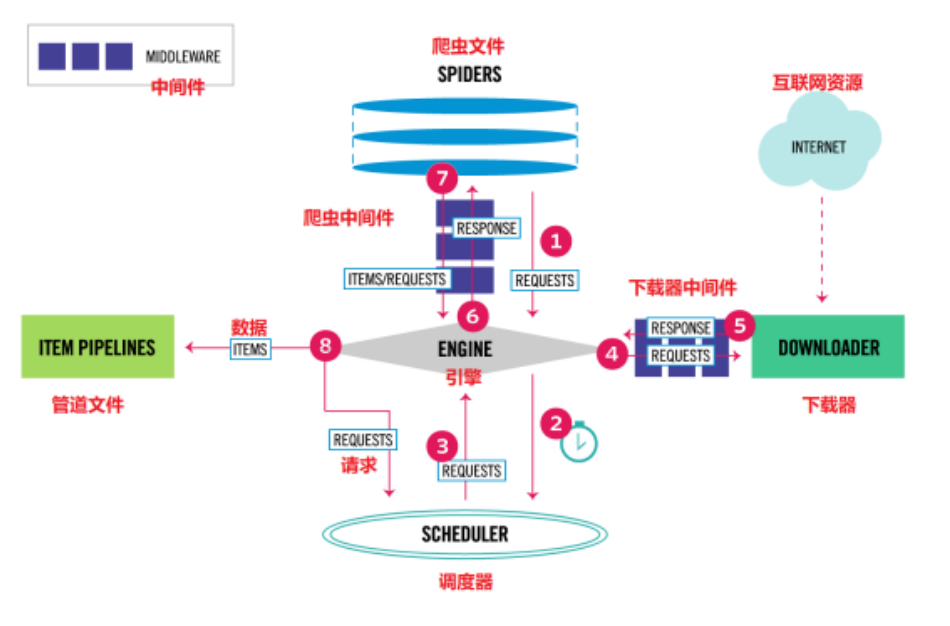

1.Engine。引擎,處理整個系統的數據流處理、觸發事務,是整個框架的核心。

2.ltem。項目,它定義了爬取結果的數據結構,爬取的數據會被賦值成該ltem對象。

3.Scheduler。調度器,接受引擎發過來的請求并將其加入隊列中,在引擎再次請求的時候將請求提供給引擎。

4.Downloader。下載器,下載網頁內容,并將網頁內容返回給蜘蛛。

5.Spiders。蜘蛛,其內定義了爬取的邏輯和網頁的解析規則,它主要負責解析響應并生成提結果和新的請求。

6.Item Pipeline。項目管道,負責處理由蜘蛛從網頁中抽取的項目,它的主要任務是清洗、驗證和存儲數據。

7.Downloader Middlewares。下載器中間件,位于引擎和下載器之間的鉤子框架,主要處理引擎與下載器之間的請求及響應。

8.Spider Middlewares。蜘蛛中間件,位于引擎和蜘蛛之間的鉤子框架,主要處理蜘蛛輸入的響應和輸出的結果及新的請求。

到此這篇關于Python爬蟲基礎之簡單說一下scrapy的框架結構的文章就介紹到這了,更多相關scrapy的框架結構內容請搜索好吧啦網以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持好吧啦網!

相關文章:

排行榜

網公網安備

網公網安備