Python+Dlib+Opencv實(shí)現(xiàn)人臉采集并表情判別功能的代碼

一、dlib以及opencv-python庫(kù)安裝

介于我使用的是jupyter notebook,所以在安裝dlib和opencv-python時(shí)是在

這個(gè)命令行安裝的

dlib安裝方法:

1.若可以,直接使用上圖所示命令行輸入以下命令:

pip install cmake

pip install boost

pip install dlib

若安裝了visual studio2019應(yīng)該就可以直接pip install dlib,至少我是這樣

由于很多在執(zhí)行第三句時(shí)都會(huì)報(bào)錯(cuò),所以這里提供第二種辦法

2.去dlib官網(wǎng):http://dlib.net/ 或者 https://github.com/davisking/dlib 下載壓縮包

下載完成后,解壓縮

在安裝dlib前需要安裝Boost和Cmake,dlib19之后你需要安裝vs2015以上的IDE,本人是安裝的vs2019,(建議先安裝好VS之后再安裝Cmake和 boost)

Cmake安裝

官網(wǎng)下載安裝包:https://cmake.org/download/

我下的是

直接安裝之后,配置環(huán)境變量

Boost下載

安裝boost:下載地址:http://www.boost.org/

如果vs安裝的是2015以上的版本,可以直接進(jìn)行下一步,最好安裝最新版本,不然會(huì)找不到b2命令

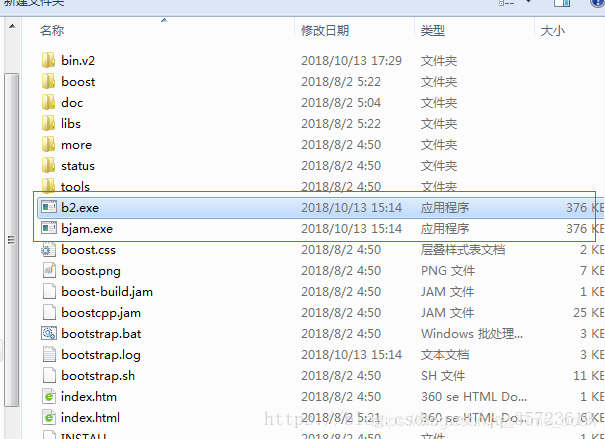

下載之后將其解壓縮,進(jìn)入boost_1_73_0文件夾中,找到bootstrap.bat批處理文件,雙擊運(yùn)行,等待運(yùn)行完成后(命令行自動(dòng)消失)會(huì)生成兩個(gè)文件b2.exe和bjam.exe

然后將這兩個(gè)文件復(fù)制到boost_1_73_0根文件夾下:同樣開啟一個(gè)命令行,定位到這個(gè)文件夾,運(yùn)行命令:

b2 install

這個(gè)安裝需要一段時(shí)間,耐心等候。

利用b2編譯庫(kù)文件:

b2 -a ?with-python address-model=64 toolset=msvc runtime-link=static

之前你cmake下載的64位這里(address-model)寫64,如果是32位的就把之前的64改成32

安裝完成后配置boost環(huán)境變量

安裝dlib

進(jìn)入你的dlib解壓路徑,輸入python setup.py install

成功之后會(huì)在文件夾中看見dlib和dlib.egg-info ,將這兩個(gè)文件夾復(fù)制到你的python安裝的目錄下的Lib文件中:

—>例如我的python環(huán)境為python2.7,

—>所以將其放在python2-7文件夾的Python2-7Libsite-packages中

—>這時(shí),就已經(jīng)完成了dlib的配置

opencv-python安裝方法

在Anaconda Prompt下輸入以下命令

pip install opencv-python

但如果一直失敗,建議在Anaconda Prompt下輸入以下命令

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple opencv-python

二、dlib的68點(diǎn)模型

dlib的68點(diǎn)模型,使用網(wǎng)絡(luò)上大神訓(xùn)練好的特征預(yù)測(cè)器,用來(lái)進(jìn)行python代碼人臉識(shí)別的特征預(yù)測(cè)。

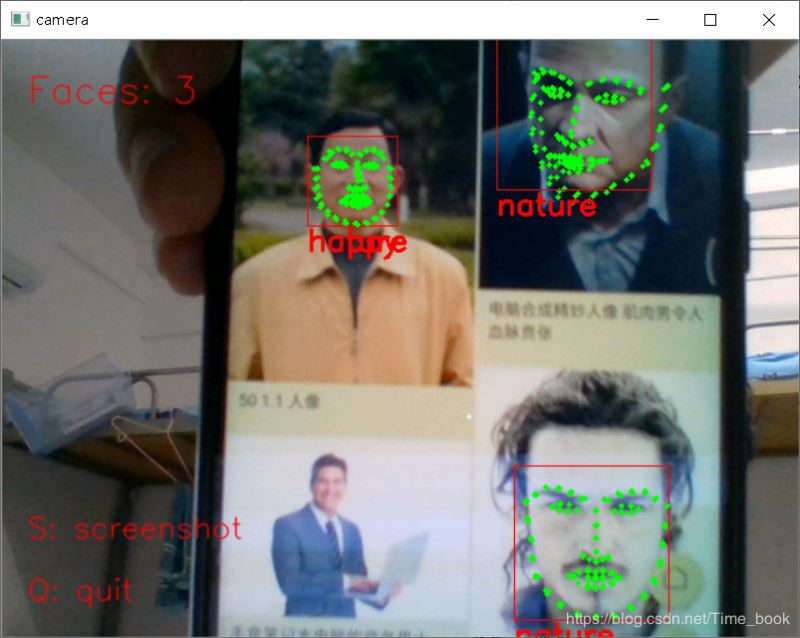

三、Python實(shí)現(xiàn)人臉識(shí)別&表情判別

'''從視屏中識(shí)別人臉,并實(shí)時(shí)標(biāo)出面部特征點(diǎn)'''import sysimport dlib # 人臉識(shí)別的庫(kù)dlibimport numpy as np # 數(shù)據(jù)處理的庫(kù)numpyimport cv2 # 圖像處理的庫(kù)OpenCv class face_emotion(): def __init__(self): # 使用特征提取器get_frontal_face_detector self.detector = dlib.get_frontal_face_detector() # dlib的68點(diǎn)模型,使用作者訓(xùn)練好的特征預(yù)測(cè)器 self.predictor = dlib.shape_predictor('F:/face.dat') # 建cv2攝像頭對(duì)象,這里使用電腦自帶攝像頭,如果接了外部攝像頭,則自動(dòng)切換到外部攝像頭 self.cap = cv2.VideoCapture(0) # 設(shè)置視頻參數(shù),propId設(shè)置的視頻參數(shù),value設(shè)置的參數(shù)值 self.cap.set(3, 480) # 截圖screenshoot的計(jì)數(shù)器 self.cnt = 0 def learning_face(self): # 眉毛直線擬合數(shù)據(jù)緩沖 line_brow_x = [] line_brow_y = [] # cap.isOpened() 返回true/false 檢查初始化是否成功 while (self.cap.isOpened()): # cap.read() # 返回兩個(gè)值: # 一個(gè)布爾值true/false,用來(lái)判斷讀取視頻是否成功/是否到視頻末尾 # 圖像對(duì)象,圖像的三維矩陣 flag, im_rd = self.cap.read() # 每幀數(shù)據(jù)延時(shí)1ms,延時(shí)為0讀取的是靜態(tài)幀 k = cv2.waitKey(1) # 取灰度 img_gray = cv2.cvtColor(im_rd, cv2.COLOR_RGB2GRAY) # 使用人臉檢測(cè)器檢測(cè)每一幀圖像中的人臉。并返回人臉數(shù)rects faces = self.detector(img_gray, 0) # 待會(huì)要顯示在屏幕上的字體 font = cv2.FONT_HERSHEY_SIMPLEX # 如果檢測(cè)到人臉 if (len(faces) != 0): # 對(duì)每個(gè)人臉都標(biāo)出68個(gè)特征點(diǎn) for i in range(len(faces)): # enumerate方法同時(shí)返回?cái)?shù)據(jù)對(duì)象的索引和數(shù)據(jù),k為索引,d為faces中的對(duì)象 for k, d in enumerate(faces): # 用紅色矩形框出人臉 cv2.rectangle(im_rd, (d.left(), d.top()), (d.right(), d.bottom()), (0, 0, 255)) # 計(jì)算人臉熱別框邊長(zhǎng) self.face_width = d.right() - d.left() # 使用預(yù)測(cè)器得到68點(diǎn)數(shù)據(jù)的坐標(biāo) shape = self.predictor(im_rd, d) # 圓圈顯示每個(gè)特征點(diǎn) for i in range(68): cv2.circle(im_rd, (shape.part(i).x, shape.part(i).y), 2, (0, 255, 0), -1, 8) # cv2.putText(im_rd, str(i), (shape.part(i).x, shape.part(i).y), cv2.FONT_HERSHEY_SIMPLEX, 0.5, # (255, 255, 255)) # 分析任意n點(diǎn)的位置關(guān)系來(lái)作為表情識(shí)別的依據(jù) mouth_width = (shape.part(54).x - shape.part(48).x) / self.face_width # 嘴巴咧開程度 mouth_higth = (shape.part(66).y - shape.part(62).y) / self.face_width # 嘴巴張開程度 # print('嘴巴寬度與識(shí)別框?qū)挾戎龋?,mouth_width_arv) # print('嘴巴高度與識(shí)別框高度之比:',mouth_higth_arv) # 通過(guò)兩個(gè)眉毛上的10個(gè)特征點(diǎn),分析挑眉程度和皺眉程度 brow_sum = 0 # 高度之和 frown_sum = 0 # 兩邊眉毛距離之和 for j in range(17, 21): brow_sum += (shape.part(j).y - d.top()) + (shape.part(j + 5).y - d.top()) frown_sum += shape.part(j + 5).x - shape.part(j).x line_brow_x.append(shape.part(j).x) line_brow_y.append(shape.part(j).y) # self.brow_k, self.brow_d = self.fit_slr(line_brow_x, line_brow_y) # 計(jì)算眉毛的傾斜程度 tempx = np.array(line_brow_x) tempy = np.array(line_brow_y) z1 = np.polyfit(tempx, tempy, 1) # 擬合成一次直線 self.brow_k = -round(z1[0], 3) # 擬合出曲線的斜率和實(shí)際眉毛的傾斜方向是相反的 brow_hight = (brow_sum / 10) / self.face_width # 眉毛高度占比 brow_width = (frown_sum / 5) / self.face_width # 眉毛距離占比 # print('眉毛高度與識(shí)別框高度之比:',round(brow_arv/self.face_width,3)) # print('眉毛間距與識(shí)別框高度之比:',round(frown_arv/self.face_width,3)) # 眼睛睜開程度 eye_sum = (shape.part(41).y - shape.part(37).y + shape.part(40).y - shape.part(38).y + shape.part(47).y - shape.part(43).y + shape.part(46).y - shape.part(44).y) eye_hight = (eye_sum / 4) / self.face_width # print('眼睛睜開距離與識(shí)別框高度之比:',round(eye_open/self.face_width,3)) # 分情況討論 # 張嘴,可能是開心或者驚訝 if round(mouth_higth >= 0.03): if eye_hight >= 0.056:cv2.putText(im_rd, 'amazing', (d.left(), d.bottom() + 20), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0, 0, 255), 2, 4) else:cv2.putText(im_rd, 'happy', (d.left(), d.bottom() + 20), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0, 0, 255), 2, 4) # 沒有張嘴,可能是正常和生氣 else: if self.brow_k <= -0.3:cv2.putText(im_rd, 'angry', (d.left(), d.bottom() + 20), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0, 0, 255), 2, 4) else:cv2.putText(im_rd, 'nature', (d.left(), d.bottom() + 20), cv2.FONT_HERSHEY_SIMPLEX, 0.8, (0, 0, 255), 2, 4) # 標(biāo)出人臉數(shù) cv2.putText(im_rd, 'Faces: ' + str(len(faces)), (20, 50), font, 1, (0, 0, 255), 1, cv2.LINE_AA) else: # 沒有檢測(cè)到人臉 cv2.putText(im_rd, 'No Face', (20, 50), font, 1, (0, 0, 255), 1, cv2.LINE_AA) # 添加說(shuō)明 im_rd = cv2.putText(im_rd, 'S: screenshot', (20, 400), font, 0.8, (0, 0, 255), 1, cv2.LINE_AA) im_rd = cv2.putText(im_rd, 'Q: quit', (20, 450), font, 0.8, (0, 0, 255), 1, cv2.LINE_AA) # 按下s鍵截圖保存 if (k == ord(’s’)): self.cnt += 1 cv2.imwrite('screenshoot' + str(self.cnt) + '.jpg', im_rd) # 按下q鍵退出 if (k == ord(’q’)): break # 窗口顯示 cv2.imshow('camera', im_rd) # 釋放攝像頭 self.cap.release() # 刪除建立的窗口 cv2.destroyAllWindows() if __name__ == '__main__': my_face = face_emotion() my_face.learning_face()

四、參考文章

https://www.jb51.net/article/189876.htm

到此這篇關(guān)于Python+Dlib+Opencv實(shí)現(xiàn)人臉采集并表情判別的文章就介紹到這了,更多相關(guān)Python Dlib Opencv 人臉采集內(nèi)容請(qǐng)搜索好吧啦網(wǎng)以前的文章或繼續(xù)瀏覽下面的相關(guān)文章希望大家以后多多支持好吧啦網(wǎng)!

相關(guān)文章:

1. asp(vbscript)中自定義函數(shù)的默認(rèn)參數(shù)實(shí)現(xiàn)代碼2. Ajax實(shí)現(xiàn)表格中信息不刷新頁(yè)面進(jìn)行更新數(shù)據(jù)3. jsp EL表達(dá)式詳解4. jsp中sitemesh修改tagRule技術(shù)分享5. JavaWeb Servlet中url-pattern的使用6. 爬取今日頭條Ajax請(qǐng)求7. 如何使用瀏覽器擴(kuò)展篡改網(wǎng)頁(yè)中的JS 文件8. ASP基礎(chǔ)知識(shí)VBScript基本元素講解9. ASP刪除img標(biāo)簽的style屬性只保留src的正則函數(shù)10. JSP servlet實(shí)現(xiàn)文件上傳下載和刪除

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備