Python Scrapy圖片爬取原理及代碼實例

1.在爬蟲文件中只需要解析提取出圖片地址,然后將地址提交給管道

在管道文件對圖片進行下載和持久化存儲

class ImgSpider(scrapy.Spider): name = ’img’ # allowed_domains = [’www.xxx.com’] start_urls = [’http://www.521609.com/daxuemeinv/’] url = ’http://www.521609.com/daxuemeinv/list8%d.html’ pageNum = 1 def parse(self, response): li_list = response.xpath(’//*[@id='content']/div[2]/div[2]/ul/li’) for li in li_list: img_src = ’http://www.521609.com’+li.xpath(’./a[1]/img/@src’).extract_first() item = ImgproItem() item[’src’] = img_src yield item

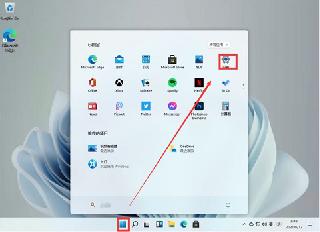

2.配置文件修改

配置文件要增加IMAGES_STORE = ’./imgsLib’表明圖片存放的路徑

3.管道類的修改

原本管道類繼承的object,處理item對象使用時process_item方法,該方法不能發(fā)送請求,要想對圖片地址發(fā)送請求,需要繼承ImagesPipeline類,然后重寫該類中的三個方法:get_media_requests,file_path,item_completed

from scrapy.pipelines.images import ImagesPipelineimport scrapyclass ImgproPipeline(ImagesPipeline): #對某一個媒體資源進行請求發(fā)送 #item就是接收到的spider提交過來的item def get_media_requests(self, item, info): yield scrapy.Request(item[’src’]) #制定媒體數(shù)據(jù)存儲的名稱 def file_path(self, request, response=None, info=None): name = request.url.split(’/’)[-1] print(’正在下載:’,name) return name #將item傳遞給下一個即將給執(zhí)行的管道類 def item_completed(self, results, item, info): return item

以上就是本文的全部內(nèi)容,希望對大家的學(xué)習(xí)有所幫助,也希望大家多多支持好吧啦網(wǎng)。

相關(guān)文章:

1. 使用Python和百度語音識別生成視頻字幕的實現(xiàn)2. Gitlab CI-CD自動化部署SpringBoot項目的方法步驟3. ASP中解決“對象關(guān)閉時,不允許操作。”的詭異問題……4. IDEA版最新MyBatis程序配置教程詳解5. python pymysql鏈接數(shù)據(jù)庫查詢結(jié)果轉(zhuǎn)為Dataframe實例6. ASP刪除img標簽的style屬性只保留src的正則函數(shù)7. idea設(shè)置自動導(dǎo)入依賴的方法步驟8. 淺談SpringMVC jsp前臺獲取參數(shù)的方式 EL表達式9. 教你如何寫出可維護的JS代碼10. 詳解Java內(nèi)部類——匿名內(nèi)部類

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備